/ サイバーセキュリティにおける生成AIとは

サイバーセキュリティにおける生成AIとは

サイバーセキュリティにおける生成AIは、防御者と攻撃者の双方にとって強力なツールです。セキュリティ部門は、生成AIの基盤である大規模言語モデル(LLM)を活用して、ポリシー、脅威検出、脆弱性管理、全体的なセキュリティ態勢を改善できる一方、脅威アクターはより危険な攻撃をさらにすばやく展開できるようになります。

生成AIの概要とサイバーセキュリティへの影響

生成AIは、サイバーセキュリティに多くの重要な影響を与えています。ただ、その詳細について掘り下げる前に、生成AIの概要とユース ケースについて説明が必要でしょう。基本的に、生成AIは機械学習を応用した技術の一種であり、人間による(場合によってはごくわずかな)指示に基づき、自然言語で書かれたコンテンツや画像を生成します。なかには動画の生成を行うものもあります。

法人向けの高度なテクノロジーには例外もありますが、生成AIのほとんどのユース ケースでは、人間のユーザーがAIエンジンに対して欲しいコンテンツを生成するように指示を出す必要があります。たとえば、テキスト生成AIに「生成AIを使ったサイバー攻撃のストーリーを書いて」と指示すると、LLMがそのようなストーリーをすばやく生成してくれます。画像についても同様で、画像生成AIに「未来的なデータ センターの画像を作って」と指示すれば、それに即した画像が生成されます。

生成AIによって、あらゆる業界のプロフェッショナルに役立つさまざまなユース ケースが実現し、一般ユーザーはまったく新しい形でコンテンツを作成して、効率を向上させることができます。ただし、今回の記事では、生成AIについてサイバーセキュリティのみの観点から取り上げていきます。

サイバーセキュリティにおける生成AIの活用法

サイバーセキュリティにおいて、生成AIは受動的防御と積極的防御のいずれにも役立てることができます。サイバーセキュリティへの生成AIプラットフォームの導入によって、以下のことを実現できます。

- 機密データのより効果的な保護:AIに与えるプロンプトやAIアプリからの出力内容をセキュリティと監査のために保持し、情報漏洩を防ぎます。

- 新たな脅威に対するセキュリティの強化:AIを活用して、Webベースやファイルベースの新たな攻撃を検出し、よりプロアクティブなセキュリティ態勢を構築できます。

- ChatGPTのようなツールの利用に伴うセキュリティの確保:ユーザーごとに異なるポリシーを設定する機能により、AIアプリケーションの使用をきめ細かく制御できます。

- AIアプリでのリスクの高いアクションの制限:アップロード、ダウンロード、コピー/貼り付けなど、データを危険にさらすアクションを防ぎます。

サイバーセキュリティにおけるAIの影響

ChatGPTの使用は、634%増加しています(2023年4月〜2024年1月)。これは、AIの影響がサイバーセキュリティを含め多くの業界に拡大していくことを意味しています。サイバーセキュリティの鍵を握るのはコンテンツ(Webトラフィックやメールなどを通じて行われるサイバー脅威や攻撃)であるため、大規模言語モデルは、トラフィックやメールに関する情報を分析し、組織がセキュリティ インシデントを予測および防止できるように最適化されていくでしょう。

それでも、セキュリティ部門はAIの脅威にAIで対抗する準備をする必要があります。また、今後は、脅威アクターや脅威グループも、組織のサイバー防御の上を行こうと生成AIを積極的に悪用するようになります。Microsoftの記事によると、生成AIを活用したサイバー攻撃は「初期段階」にあり、「特段目新しいものや特徴的なものは確認されていない」とのことです。脅威アクターの活動を阻止するために、OpenAIは攻撃者のアカウントを閉鎖していますが、脅威グループの数が増え続けるなか、アカウントの追跡と閉鎖は難しくなっていくでしょう。

さらに、各国の政府が介入し、組織レベルでの生成AIの使用に関するガイドラインが設定されるのも時間の問題です。生成AIについてはまだ不明な点が多い状況ですが、いずれデータ侵害や情報漏洩が発生し、百万ドル単位の損失を被る組織が出始め、政府が介入や規制に乗り出すことを余儀なくされると考えられます。

サイバーセキュリティにおける生成AIの応用

生成AIには、サイバー脅威の検知と対応、セキュリティの自動化など、多くのユース ケースがあります。

脅威の検知と対応能力の向上

生成AIは、「正常な」挙動を表すデータを分析してベースラインを設定し、これによって脅威の存在を示唆する逸脱を特定できます。さらに、マルウェアのシミュレーションを生成してその挙動を把握し、新たな脅威を特定することも可能です。

予測機能の強化

生成AIは、大量のデータを取り込むことにより、将来のセキュリティ イベントの参照フレームを作成し、予測型の脅威インテリジェンス、そして脆弱性管理をも実現します。

反復タスクの自動化

生成AIは、アプリケーションに関連する履歴データに基づいて、脆弱性を予測し、パッチの推奨や自動的な適用を行うことができます。また、インシデント対応の自動化もできるため、人間の介入の必要性を減らすことができます。

フィッシングの防止

生成AIは、メッセージの意図を隠そうとするメールの言語パターンおよび構造の分析、特定を通じ、フィッシング メールの検出、フィルタリングを行うモデルの生成に役立ちます。また、悪意のあるURLを分析およびブロックするためのモデルも作成できます。

生成AI導入の課題とリスク

生成AIは、一般的にはコンテンツの生成と組織の効率化をこれまでにない形で強化する可能性を持っているものの、この技術の課題を理解することも重要です。

サイバー犯罪者による悪用

生成AIツールは誰でも使用できるため、良識のある組織は効率性やサイバーセキュリティの向上のために生成AIを使用する一方、脅威アクターは生成AIツールを使用して悪事を働きます。MicrosoftとOpenAIはすでに、脅威グループによるサイバー攻撃活動の組織化の試みを明らかにしています。

データ品質の問題

AIプラットフォームのトレーニングに高品質なデータを提供できない組織は、そのプラットフォームを使用しても十分な有効性を得られないでしょう。さらに、生成AIで生成したデータでAIプラットフォームをトレーニングしようとすると、結果として得られるデータはさらに不正確なものになり、サイバーセキュリティ上の重大な問題につながる可能性もあります。

技術的な限界

生成AIモデルを効果的にトレーニングするには、大量のデータが必要です。そのため、限られたデータにしかアクセスできない組織やニッチ市場の組織では、十分な量のトレーニング データセットの収集に苦戦を強いられる可能性があります。さらに、生成AIアプリケーションによるリソースの圧迫や必要とされるメンテナンス量に起因して、さらなる課題が生まれます。

生成AIを安全に採用するためのベスト プラクティス

生成AIは誰にとっても新しいものです。そのため、リーダーは組織内での使用アプローチに注意する必要があります。生成AIの利用にあたって従業員と組織を保護するためのベスト プラクティスを以下に紹介します。

- AI活用型ツールに伴うリスクを継続的に評価して軽減し、知的財産、個人データ、顧客データを保護する。

- 関連する法律と倫理基準(データ保護規制やプライバシー法を含む)に準拠した方法でAIツールを使用する。

- AIツールの開発と展開に対する説明責任を明確化し、AIプロジェクトを監督するための役割と責任を定義する。

- AIツールを使用する際の透明性を維持すると同時に、その使用が正当であることを証明し、使用目的を関係者に明確に伝える。

AIの安全な使用とAIを悪用した脅威からの保護についての詳細は、2024年版 Zscaler ThreatLabz AIセキュリティ レポートでご確認ください。

サイバーセキュリティにおけるAIの未来:注視すべき動向

前述のとおり、いずれ各種規制によって生成AIの使用に制約がかかることが見込まれます。しかし、生成AIは今後もイノベーションを続け、サイバーセキュリティ部門はそれを積極的に活用しようとするでしょう。

セキュリティ部門やコンプライアンス部門に役立つと考えられるAIの活用方法を以下に紹介します。

- 地理的なリスク分析:将来的には、AIを使用して地政学的なデータやソーシャル メディアの傾向を分析し、攻撃リスクの高い地域を予測できるようになります。

- 行動生体認証:キーストロークやマウスの動きなど、ユーザーの行動パターンを分析することで、悪意のあるアクティビティーや不正行為を示す可能性のある異常を検出することができます。

- コンテンツ認証:AIを使用して、音声、動画(ディープフェイクなど)、テキストの信憑性を検証し、誤情報の拡散に対抗できるようになります。

- コンプライアンスの自動化:システムやプロセスを定期的にスキャンしてすべての要件に確実に準拠し、規制の高度化にも対応できるようになります。

Zscalerによる生成AIの保護

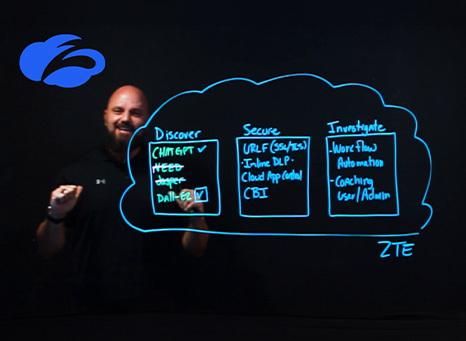

Zscaler Zero Trust Exchange™を使用すると、ユーザーがアクセスできる生成AIサイトとその対話方法(直接またはブラウザー分離経由)に関するポリシーを作成、施行できるため、機密データの保護が可能になります。

Zscalerでは、以下のようなことを可能にするイノベーションを通じ、生成AIの利用に伴う安全性とセキュリティを確保します。

- ChatGPTの使用状況の把握:ChatGPTの使用に関するアクティビティーとプロンプトを示す完全なログを保持します。

- 特定のAIアプリの制御:ユーザーがアクセスできるAIツールとアクセスできないAIツールを定義して施行します。

- 完全なデータ セキュリティの統合:機密データがAIへのプロンプトやクエリーを介して流出しないようにします。

- AIツールへのデータのアップロード制限:プロンプトを許可する一方で、重要なデータの一括アップロードを防ぐきめ細かな制御を実装します。

機密データを危険にさらすことのないよう生成AIの使用を制御する仕組みの詳細は、デモを依頼してご確認ください。

Zscalerの2025年のサイバーセキュリティの予測で、生成AIが悪用される仕組みをご確認ください。

おすすめのリソース

よくある質問

よくある質問

サイバーセキュリティにおける生成AIと同様、機械学習(ML)も大規模なデータセットの分析、モデルの構築、そのモデルによるトラフィックとコンテンツの異常に関する正確な予測において、セキュリティ部門の負担軽減に役立つと考えられます。

AIが脅威インテリジェンスや分析の前線を担うようになっても、組織が各種規制に準拠した健全な環境を維持するには、サイバーセキュリティの専門家が必要となることに変わりありません。

悪意のあるアクターは、すでに生成AIをディープフェイク詐欺、生体認証の回避、脆弱性の発見に利用しています。最近ではシンガポールでの脅迫の事例が報告されています。

Zscaler DeceptionとZscaler Risk360は、どちらも生成AI機能を活用しています。Zscaler Deceptionでは、AIを活用したハニーポットの展開と生成AIインフラの模倣によって潜在的な脅威アクターを欺き、Zscaler Risk360では、生成AIを使用して組織のリスク ポスチャーに関する最新情報を提供し、推奨される是正措置を提案します。

さらに、予測AIと生成AIを組み合わせて侵害を予測し、ポリシーを施行する「Breach Predictor」と、組織全体のユーザーのデジタル エクスペリエンスに関する包括的なインサイトを提供するAIアシスタント「Copilot」のリリースも予定されています。Breach PredictorとCopilotの詳細をご確認ください。