Zscalerのブログ

Zscalerの最新ブログ情報を受信

ZscalerでChatGPTなどの生成AIツールの安全性とセキュリティを確保

この数週間、RSAカンファレンスや米国東海岸各地で50人以上のCISOやセキュリティ専門家と会話をするなかで、金融、製造、ITサービスなどの業種の経営者の多くが、ChatGPTなどの生成AIを最重要課題として捉えていることがわかりました。特に多くの質問を受けたのが以下のような点です。

- ChatGPTをブロックするためにZscalerはどのような制御を提供しているか

- ChatGPTを完全にブロックするのではなく、従業員が安全に活用できるようにするにはどうすればよいか

- 従業員によるChatGPTや生成AIの使用方法を制御するために、他の組織ではどのような取り組みが行われているか

- ChatGPTでの情報漏洩を防ぎ、最近のSamsungの件のような状況を回避するにはどうすればよいか

- ChatGPTなどのAI/MLツールの効果的なユース ケースを活用するために、Zscalerではどのような取り組みを行っているか

この6か月間、ChatGPTの利用は消費者や企業の間で拡大しており、CopymaticやAI21などの他のAIツールも同様の状況です。特に欧州連合(EU)やグローバルな金融業界に属する比較的規模の大きいお客様の多くは、こうしたツールを安全に導入するためのポリシー フレームワークの策定に取り組んでいます。

利便性と安全性の両立を実現するインテリジェントなアクセス制御

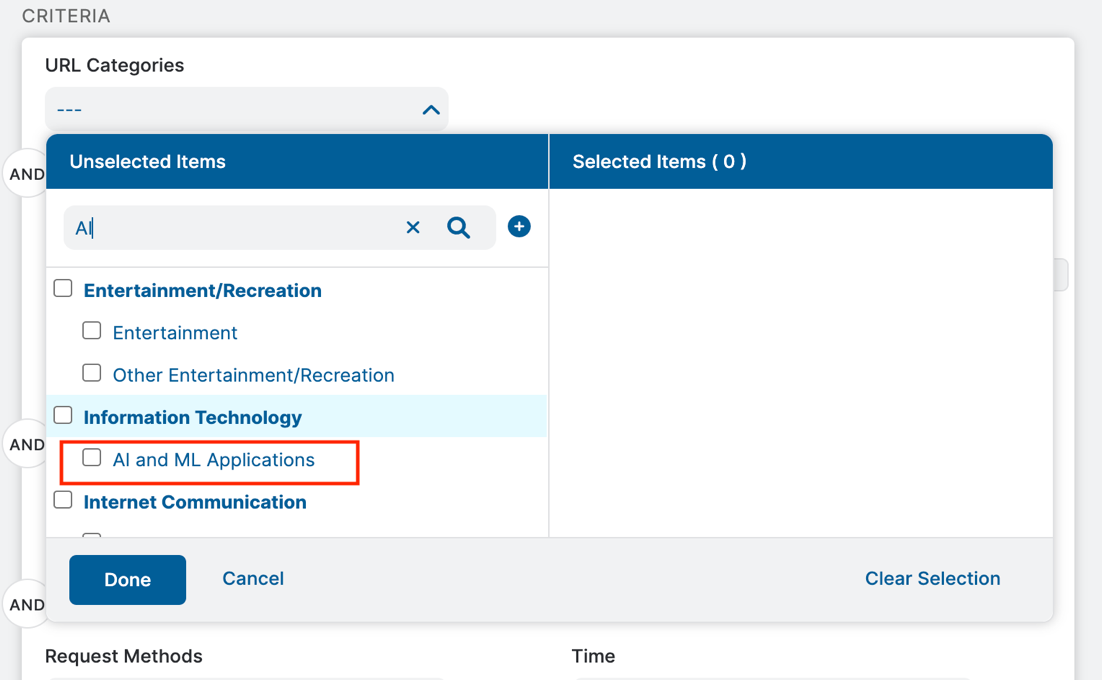

Zscalerでは、OpenAIのChatGPTのようなツールやサイトを多数特定し、[AI and ML Applications]というURLカテゴリーを作成しました。これを利用することで、さまざまな生成AI/MLツールに対して以下のアクションを実行できます。

- アクセスのブロック(金融などの規制が厳しい業界でよく使用される制御)

- 警告ベースのアクセス(生成ツールの使用にリスクがあるユーザーへの教育)

- アクセスの分離(ブラウザー分離を通じてのみアクセスを許可し、ツールからの出力をダウンロード不可とすることで知的財産権/著作権の問題を防止)

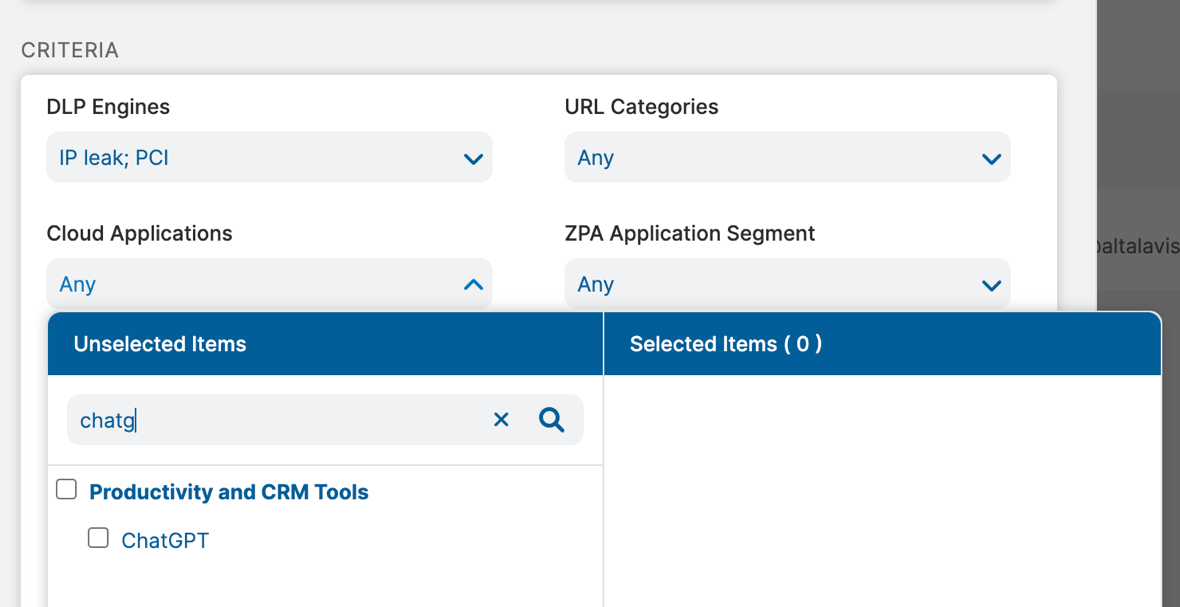

ChatGPTに関するきめ細かいDLP制御

ChatGPTは最も人気のあるAIアプリケーションです。そこで、Zscalerでは事前定義されたクラウド アプリケーションの設定として[ChatGPT]を作成し、より予防的な制御を提供しています。多くの組織は、ChatGPTへのアクセスのブロックを望んでいないものの、情報漏洩に対する不安やアップロードしたコンテンツに関する知的財産権上の損失を懸念しており、そのような場合には、きめ細かいDLP制御も有効化できます。

また、Zscaler DLPのポリシーによって厳格なデータ保護ポリシーを設定することもできます。OpenAIはHTTPS経由で利用できるため、ZscalerのインラインSSL復号を通じて、ユーザーがChatGPTに送信したコンテンツ/クエリー、ダウンロードしたコンテンツに対する完全な可視性を得られます。

この短いデモ動画では、ChatGPTへのクレジット カード番号のアップロードをZscaler DLPでブロックする様子を紹介しています。Zscaler DLPは、インラインでのポリシー適用を通じシンプルな形で情報漏洩を防ぎます。また、Zscalerの定義済みの辞書を活用して、ソース コードにも同様の機能が適用されます。

ChatGPTの使用状況とクエリーに関するインサイト

さらに、多くのお客様から「DLPによる制御アクションを実行するかどうかによらず、従業員がChatGPTに送信したクエリーを確認することも可能か」という質問がありました。これももちろん可能で、ZscalerのDLPポリシーと統合型のインシデント レシーバーを活用して行います。

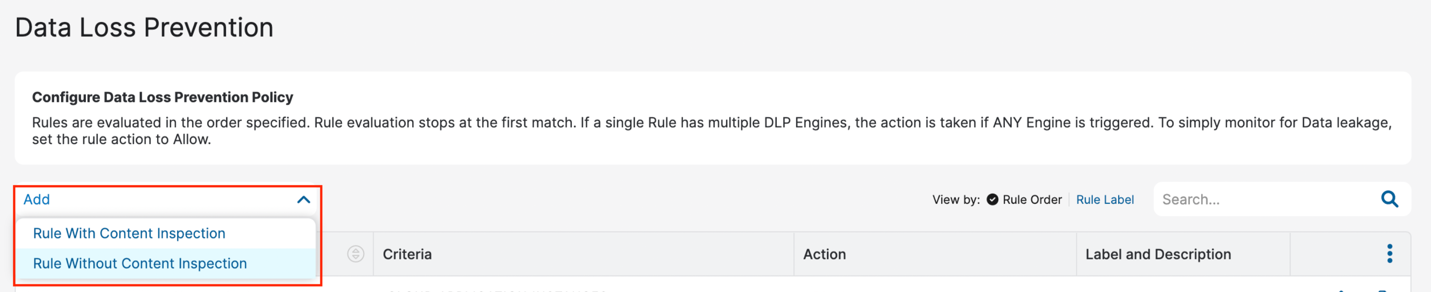

この短いデモ動画では、データ保護ポリシーで[Rule Without Content Inspection]を構成する方法を紹介しています。この方法を使うと、ChatGPTに対する0バイトを超えるHTTP POSTリクエストをすべてキャプチャーし、それをZscaler Incident Receiverに送信できます。Zscaler Incident Receiverは、キャプチャーしたChatGPTへのPOSTを組織のインシデント管理ツールや監査担当者のメールボックスに送信できます。

この機能によって、セキュリティ上の不安を解消し、従業員が組織の環境内でChatGPTを安全に使用できるようになります。

ChatGPTに関するサイバー セキュリティ上の懸念

ChatGPTやそれに類する多くのツールは、乱用や悪意のあるコードの作成を防ぐ設計になっていますが、倫理的ハッキングやペネトレーション テストを目的としたものであるという口実でコードの生成を誘導される場合があり、そのコードを微調整することでマルウェアが作成される可能性もあります。このようなマルウェアで公に知られている例はまだ存在しないかもしれませんが、ダーク ウェブ上にはそうした話題が十分に出ており、注意が必要です。

また、多くのメール セキュリティ製品は、自然言語処理技術を使用してフィッシング攻撃やソーシャル エンジニアリング攻撃を特定していますが、ChatGPTはスペル ミスや文法上の誤りを避けて完璧なメールの作成を支援してくれるため、こうした制御はあまり効果とは言えなくなってきています。

次のステップ

ChatGPTなどの生成AIの導入は一般化しつつあり、近いうちにも「エンタープライズ バージョン」が登場し、これがCASB、保存データのスキャン、SSPMなどといった既存のサイバー セキュリティ制御やデータ セキュリティ制御を拡張することになるでしょう。

Zscalerは過去数年にわたり、サイバー セキュリティからAIOpsまで、プラットフォーム全体でAI/MLを活用し、さまざまな難題を解決してきました。Zscalerでは、機械学習機能を通じて、新たに発見されたWebサイトの分類、フィッシングやボットネットの検出、DNSトラフィックのエントロピー分析による悪意のあるDNSの検出が可能です。さらに、根本原因分析を自動化し、ユーザー エクスペリエンスの問題をよりプロアクティブに解決できます。

最近では、Zscalerサービス向けのデジタル アシスタント「ZChat」のプロトタイプも発表しました。現在、このテクノロジーをサイバー セキュリティやデータ保護のユース ケースに拡張することを検討しており、当社の年次イベント「Zenith Live」では生成AIに関する魅力的なイノベーションの発表を予定しています。

イベントでの発表内容にぜひご注目ください。

このブログは役に立ちましたか?

免責事項:このブログは、Zscalerが情報提供のみを目的として作成したものであり、「現状のまま」提供されています。記載された内容の正確性、完全性、信頼性については一切保証されません。Zscalerは、ブログ内の情報の誤りや欠如、またはその情報に基づいて行われるいかなる行為に関して一切の責任を負いません。また、ブログ内でリンクされているサードパーティーのWebサイトおよびリソースは、利便性のみを目的として提供されており、その内容や運用についても一切の責任を負いません。すべての内容は予告なく変更される場合があります。このブログにアクセスすることで、これらの条件に同意し、情報の確認および使用は自己責任で行うことを理解したものとみなされます。